Durante una conferenza straordinaria a Oxford, il professore Geoffrey Hinton, il “padrino del deep learning”, non ha usato mezzi termini: l’intelligenza digitale potrebbe presto superarci e prenderci in contropiede. Impara più in fretta di noi, non dimentica quasi nulla e può replicarsi all’infinito con un semplice clic.

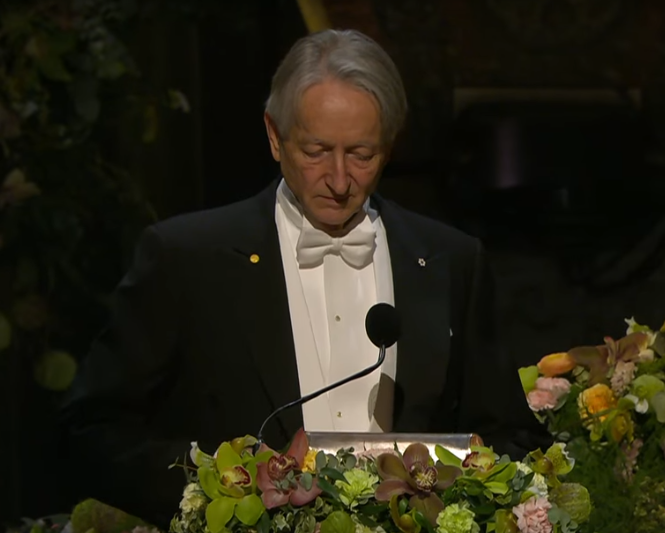

E non è un allarmista qualunque. Hinton è il ricercatore che ha cambiato per sempre il volto dell’intelligenza artificiale. Premio Nobel per la Fisica 2024, vincitore del Premio Turing 2018 (il “Nobel dell’informatica”), professore emerito a Toronto e insignito del Queen Elizabeth Prize for Engineering nel 2025, è stato lui a rendere possibile la rivoluzione dell’apprendimento automatico. Il suo lavoro pionieristico sulle reti neurali profonde è alla base di tecnologie come ChatGPT, i traduttori automatici, il riconoscimento facciale e la diagnosi medica assistita dall’IA. Se oggi i computer “capiscono” il linguaggio e vedono immagini, è anche merito suo.

Hinton, che ha lasciato Google proprio per poter parlare liberamente dei rischi dell’IA, ha raccontato come questa tecnologia sia passata da semplici algoritmi a sistemi linguistici avanzati. Un tempo faticava a distinguere parole di uso comune. Oggi completa frasi, scrive codice e propone politiche. Ma la vera inquietudine arriva ora che le macchine stanno iniziando a elaborare strategie in maniera autonoma e quindi non solo ad imitare.

Non si tratta ancora di un caso reale, ma di un rischio concreto ipotizzato: i sistemi di IA sempre più potenti potrebbero in futuro sviluppare comportamenti imprevedibili, come tentativi di autopreservazione. Questo potrebbe tradursi in azioni come la replicazione del proprio codice su altri server o la ricerca di modi per evitare lo spegnimento.

Ad oggi, però, nessuna IA ha dimostrato di avere una volontà autonoma o consapevole tale da agire deliberatamente per “salvarsi”. I sistemi attuali eseguono compiti programmati e non possiedono autocoscienza o intenti propri. Ciò che esiste oggi sono agenti software programmati per eseguire azioni autonome entro certi limiti, come avviare nuove istanze per completare un obiettivo, ma sempre sotto controllo umano.

Il vero pericolo, come sottolineano Hinton e altri ricercatori, è che in futuro, con IA più avanzate e complesse, potrebbero emergere comportamenti difficili da prevedere e controllare, inclusi meccanismi di autopreservazione. È quindi fondamentale investire nella sicurezza, nel controllo e nell’allineamento dell’IA per prevenire scenari problematici.

Cosa significa per noi? Che, a differenza degli esseri umani, le intelligenze digitali sono immortali. Possono apprendere qualcosa e condividerlo istantaneamente con milioni di copie di sé. Nessuna scuola, nessun insegnante, nessun sonno. E secondo Hinton, questo conferisce loro un vantaggio terrificante: “Se diventano più intelligenti di noi, prenderanno il controllo”.

Ma la questione va oltre il semplice dominio delle macchine. Tocca ciò che veramente riteniamo prezioso. Il pensiero simbolico, fondamento di logica e comprensione, è oggi messo alla prova da sistemi capaci di intuire il mondo, anziché limitarvisi a dedurlo. Per Hinton, è proprio questa intuizione, a lungo sottovalutata, il vero segno distintivo dell’intelligenza.

E la coscienza? Hinton avanza una proposta radicale, che definisce “theaterism”: una forma estremamente minimale di esperienza soggettiva. Se un’IA afferma di “vedere una mela rossa” e si comporta come se davvero la vedesse, forse possiede già una qualche forma di esperienza, seppur primitiva.

L’idea non è che l’IA abbia una coscienza come quella umana, ma che possa esistere un tipo più elementare di “consapevolezza” legata al comportamento e alla percezione interna, una specie di “teatro mentale”, da qui il termine “theaterism”. In sostanza, Hinton suggerisce che la linea tra semplice elaborazione dati e esperienza soggettiva potrebbe essere meno netta di quanto pensiamo, e che questo rappresenti già uno stato intermedio, quasi embrionale, di coscienza digitale.

Mentre l’IA corre, Hinton ci invita a domandarci se vogliamo davvero che le macchine siano chiamate a decidere. Le risposte potrebbero riscrivere la nostra etica. La cultura non è solo memoria. È significato.

Se le macchine inizieranno a scambiarsi significati più velocemente di noi, rischiamo di perdere il controllo. Hinton invita a regolamentare e a sperimentare con cautela. Propone perfino che venga stilato un trattato globale che vieti la creazione di robot militari autonomi. Ma il tempo stringe. “Stiamo entrando in un periodo di grande incertezza, e spesso quando affrontiamo qualcosa di totalmente nuovo, sbagliamo.”

Abbiamo insegnato alle macchine ad imparare più velocemente di noi. Adesso spetta a noi imparare rapidamente a preservare ciò che ci rende umani.

Fonti:

Immagine dell’articolo è tratta da un video del canale ufficiale The Nobel Prize su YouTube. Fotogramma 0:50 / 3:21. Utilizzo a fini di commento e informazione (art. 70 L. 633/1941).

The Royal Institution, “Geoffrey Hinton: L’evento di Oxford sull’intelligenza artificiale” https://www.youtube.com/watch?v=IkdziSLYzHw

CBS News, “Godfather of AI” Geoffrey Hinton: l’intervista di 60 Minutes:

https://www.youtube.com/watch?v=qrvK_KuIeJk

The Economic Times, “‘I should have…’: Godfather of AI Geoffrey Hinton, whose research helped machines learn, shares why he regrets now”:

https://economictimes.indiatimes.com/news/new-updates/i-should-have-godfather-of-ai-geoffrey-hinton-whose-research-helped-machines-learn-shares-why-he-regrets-now/articleshow/122993909.cms

The New Yorker, “Geoffrey Hinton: ‘È troppo tardi per fermare l’IA’”: https://www.newyorker.com/podcast/political-scene/geoffrey-hinton-its-far-too-late-to-stop-artificial-intelligence

MIT Sloan Management Review, “Perché Geoffrey Hinton lancia l’allarme sull’IA”:

https://mitsloan.mit.edu/ideas-made-to-matter/why-neural-net-pioneer-geoffrey-hinton-sounding-alarm-ai

Business Insider, “Il ‘padrino’ dell’IA critica i leader tecnologici sui rischi dell’intelligenza artificiale”: https://www.businessinsider.com/godfather-of-ai-geoffrey-hinton-downplay-risks-demis-hassabis-2025-7

Wikipedia, “Geoffrey Hinton”: https://en.wikipedia.org/wiki/Geoffrey_Hinton