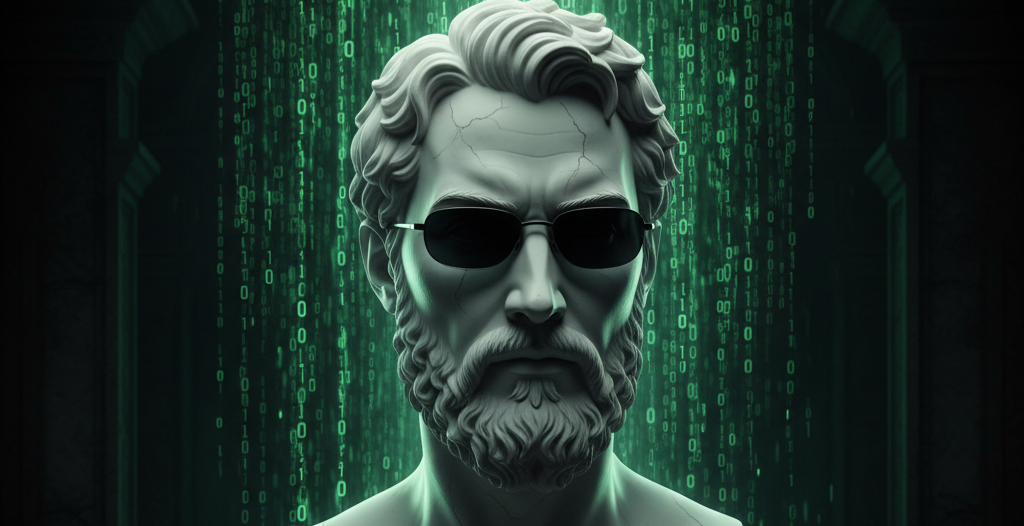

Nel famoso film del 1999 “The Matrix” l’umanità è stata sottomessa dalle Intelligenze Artificiali e vive in una simulazione neurale interattiva.

Ma il protagonista Neo, come nell’“Allegoria della caverna” di Platone, può andare oltre. Lui vede il calcolo, l’intreccio di dati, convertito dalle macchine in segnali inviati al nostro cervello per tenerci schiavi in una realtà virtuale chiamata appunto “la Matrice”.

Senza andare troppo lontano con la fantascienza, sono proprio le strutture matematiche chiamate matrici a permettere ai computer di creare immagini tridimensionali, far muovere i personaggi nei videogiochi e alimentare i sistemi di Intelligenza Artificiale. Ogni azione digitale, perfino ogni parola generata da un sistema come ChatGPT, è il risultato di un numero enorme di calcoli eseguiti attraverso queste tabelle numeriche.

I computer che utilizziamo oggi sono macchine digitali, cioè funzionano leggendo e manipolando solo due stati: 0 e 1, acceso o spento. Questo approccio, che ha reso possibile la rivoluzione informatica, sta però incontrando limiti sempre più evidenti. Il grande boom delle IA ci sta facendo capire che, nonostante i grandi risultati, le capacità computazionali dei calcolatori attuali stanno giungendo alla fine. Da un lato abbiamo il cosiddetto collo di bottiglia di Von Neumann, dove enormi quantità di energia vengono sprecate spostando dati tra memoria e processore. Dall’altro, abbiamo la crisi della legge di Moore che prevede il raddoppio dei componenti fondamentali dei chip ogni due anni. Ma i transistor, sono ormai così piccoli da avvicinarsi alle dimensioni atomiche, rendendo sempre più difficile ridurli ulteriormente senza incorrere in problemi fisici insormontabili.

Per superare questi ostacoli, si sta riscoprendo l’informatica analogica. A differenza di quella digitale, non si basa su 0 e 1, ma su segnali continui, come la corrente elettrica o il movimento meccanico di ingranaggi. Non si tratta di una novità assoluta: uno dei primi esempi di calcolatore analogico infatti è il Meccanismo di Antikythera, un sofisticato dispositivo greco di oltre duemila anni fa utilizzato per prevedere i movimenti dei corpi celesti. L’aspetto più interessante dell’analogico, soprattutto per l’Intelligenza Artificiale, è la possibilità di sfruttare direttamente le leggi della fisica per eseguire le moltiplicazioni tra matrici tipiche delle reti neuronali. In questo modo, anziché coordinare migliaia di minuscoli interruttori elettronici, il risultato emerge naturalmente dal comportamento dei materiali, con una drastica riduzione del consumo energetico.

Negli ultimi anni, diverse aziende e centri di ricerca stanno riportando questa tecnologia al centro dell’innovazione. La società statunitense Mythic ha sviluppato chip che utilizzano la memoria flash, simile a quella delle chiavette USB, per eseguire calcoli di Intelligenza Artificiale con un consumo energetico molto ridotto. Ricercatori dell’Università di Pechino hanno realizzato chip basati su tecnologia RRAM che promettono velocità e efficienza energetica nettamente superiori rispetto ai processori tradizionali, inclusi quelli prodotti da Nvidia.In Germania, l’azienda Anabrid commercializza un piccolo computer analogico chiamato “The Analog Thing”, pensato per aiutare studenti e ricercatori ad affrontare problemi complessi con un approccio diverso rispetto ai computer convenzionali.

L’impatto di questi progressi potrebbe essere enorme. Un esempio di ciò che la potenza di calcolo può già fare è AlphaFold, il sistema sviluppato da DeepMind che ha determinato la struttura di circa 200 milioni di proteine, un risultato che avrebbe richiesto tempi lunghissimi con i metodi tradizionali.

Con l’evoluzione dei chip analogici, in futuro potremmo disporre di dispositivi medici, sensori e strumenti intelligenti capaci di funzionare per anni con una piccola batteria, elaborando dati e apprendendo direttamente sul posto, senza dover dipendere costantemente da una connessione a Internet.

Se nel film le macchine del futuro hanno fame di energia e dominano l’uomo, nella realtà potrebbero consumare poco e amplificare le nostre capacità.

Il rischio quindi non è che le macchine pensino troppo, ma che l’umanità smetta di farlo: Platone lo aveva già intuito, invitandoci a non preferire la comodità delle ombre sulla parete alla luce fuori dalla caverna.